こんにちは、山田どうそんです。

これから動画編集スキルを身につけて稼げるようになりたいという方が、まずは一番最初に知識として身につけておきたい基本的なことについて解説します。

動画に関する基礎知識

動画を編集する上で最低限身につけておかなければいけない知識をご紹介します。

これらの知識がないと細かいところでつまづく可能性がありますので、これから動画編集をスタートさせたいという初心者の方はこれらの知識をしっかりと理解しておくことが大事です。

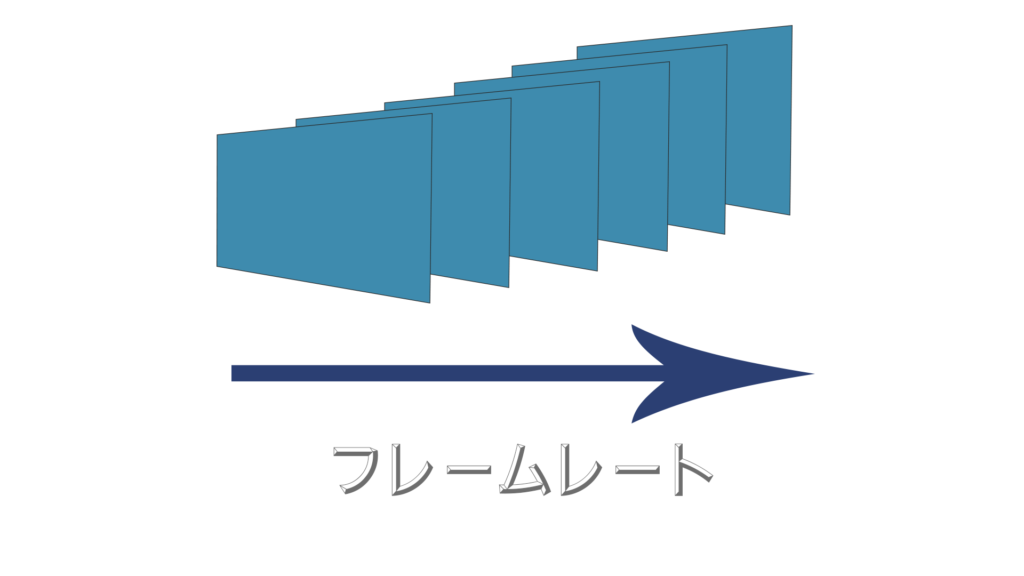

フレームレートについて

動画というのはパラパラ漫画のように1枚1枚の画像が高速で繋がってできています。この1枚の画像のサイズがフレームサイズと言います。

そして、1秒間の画像の枚数がフレームレートになります。

フレームレートは、「30fps」などのように表現されます。

fps(フレーム・パー・セコンド)の略です。

30fpsというのは1秒間に30枚の画像が差し込まれていることを意味しています。

フレームレートが高くなると画像が滑らかになり美しい映像になります。しかし、それと同時にデータの容量も大きくなります。

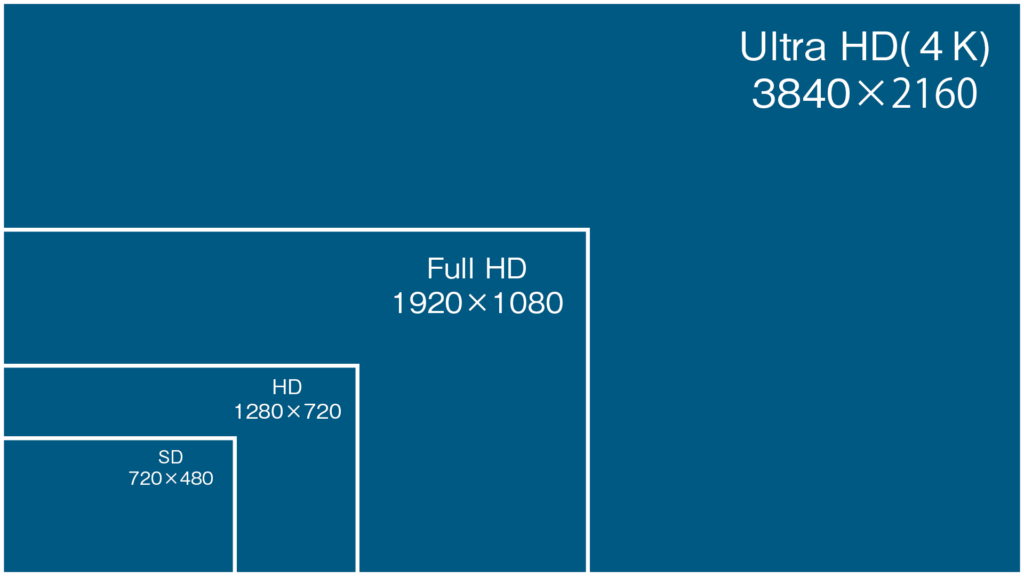

フレームサイズについて

動画の世界でよく使われているフレームサイズをいくつかご紹介します。

Full HDは一般的によく利用されているフレームサイズで綺麗な映像でありながらデータ容量がそれほど大きくならないので一番利用されるサイズ形式です。

最近では、高画質な映像を撮影できる4K(Ultra HD)もよく利用されるようになってきています。

16:9の場合は3840×2160で、デジタルシネマ規格の場合は4096×2160で17:9です。

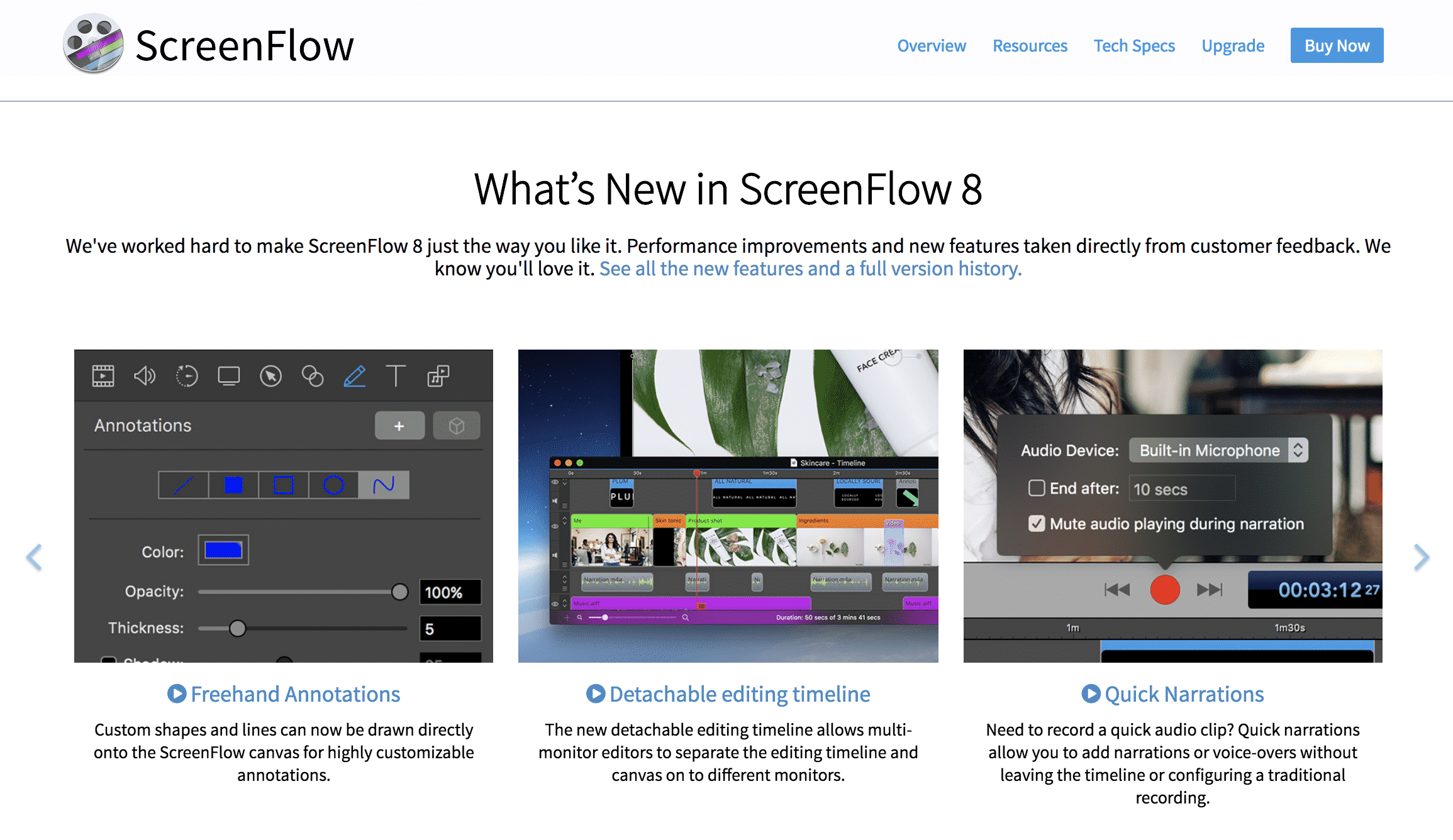

4KはFull HDの4倍ですからかなり画質が綺麗になりますが、その分データ容量がとても大きくなります。低スペックのカメラでは利用できませんし、低スペックのパソコンでも編集はできません。

4Kを扱う場合は、Adobe Premiere ProやFinal Cut Pro Xなどのような高機能動画編集ツールが必要になります。

プログレッシブ形式とインターレース形式について

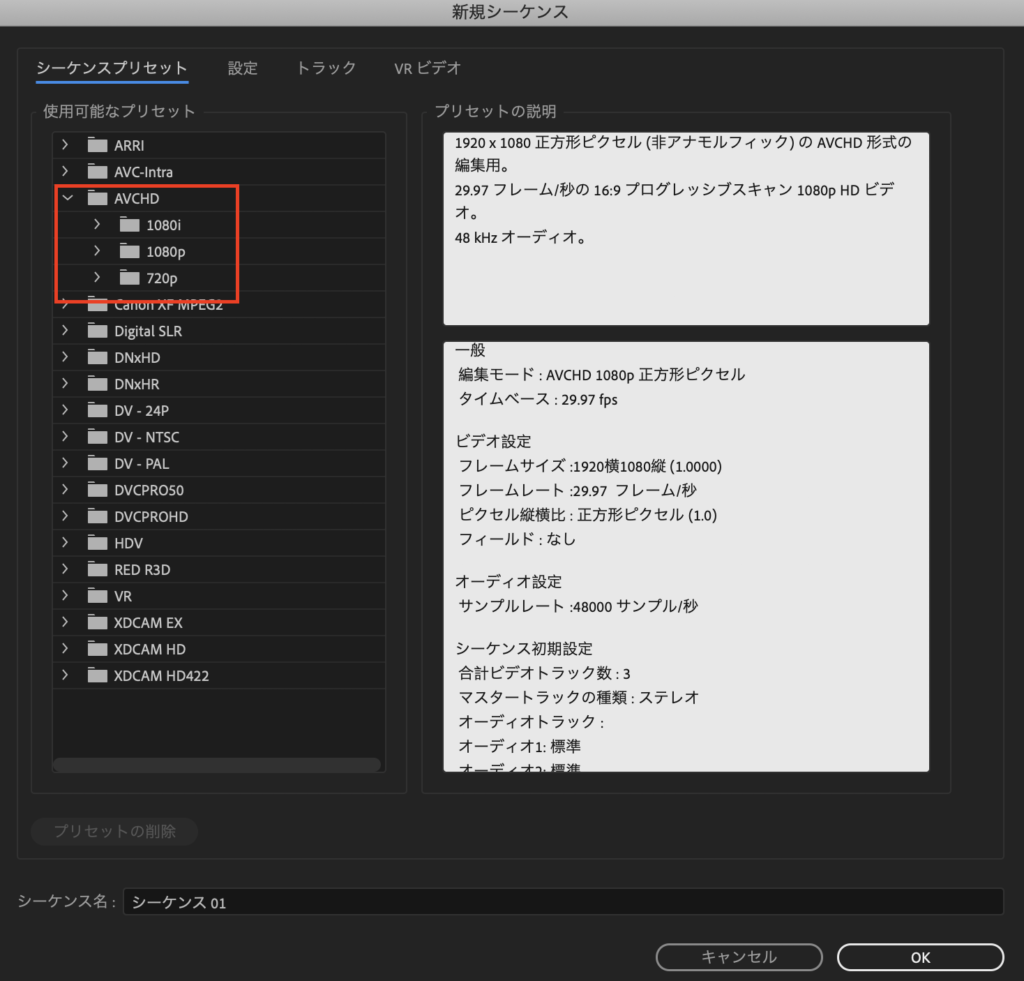

これは、Premiere Proの新規シーケンスを作成するダイアログボックスの画面です。

「AVCHD」>「1080i」「1080p」という2種類のシーケンス作成プリセットがあるのがわかると思います。

「i」というのはインターレース方式という意味で、「p」というのはプログレッシブ方式のことを意味しています。

この2つは大きく意味合いが異なりますので知識としてしっかりと覚えておいた方がいい部分です。

インターレース方式について

詳しい解説は、より専門的なサイトを調べてもらえればわかりますが、簡単に説明するとインターレース形式の場合1枚の画像を二回に分けて交互に送信する方法です。

これは、走査線というものを1本飛ばしで描画している方法になります。

飛び越し走査方式とも呼ばれていて、日本のテレビ放送はこの方式を採用しています。これをNTSC方式と言います。

つまり、インターレース方式の場合2枚の画像で1枚の画像が表示されるということになります。

ということは、60iというのは、60フレームありますが実質は30枚の画像を表示していることになるわけです。

インターレース方式は1秒あたりに更新する枚数が2倍になるのでプログレッシブ方式に比べて画像が滑らかになるというメリットがあります。

プログレッシブ方式について

プログレッシブ方式は全ての画像をそのまま表示させるので画像1枚あたりの解像度はプログレッシブ方式の方が高くなります。

現在インターネットで利用されているストリーミング形式の映像、例えばYouTubeやニコニコ動画、スマホ動画などは全てプログレッシブ方式を利用しています。

現在、パソコンで利用されている液晶ディスプレイは走査線というものが存在しませんので、プログレッシブ方式が利用されているんです。

主にYouTubeなどの動画編集をする人はこちらのプログレッシブ方式「p」とついているシーケンスプリセットを使うといいでしょう。

コンテナとコーデックについて

動画をビジネスとして扱う上でコンテナとコーデックの知識は必須と言えます。これがわからないと、相手にデータを渡したときに、「再生できない」というケースが出てしまう可能性があるからです。

コンテナとは

コンテナとは動画ファイルの箱だと思ってください。動画は、映像と音声の2種類で成り立っています。

この2つを入れる箱がコンテナです。

これがコンテナのイメージです。

このコンテナの種類が動画ファイルの種類になっていて拡張子にもなっています。

MP4(.mp4)、WMV(.wmv)、AVI(.avi)、FLV(.flv)などのようなものがコンテナの種類です。

そして、動画再生するソフトを「メディアプレイヤー」と言いますが、これには様々な種類のものがあります。

例えば、MacであればQuickTimePlayerが有名ですし、Windowsであれば、Windows Media Playerがあります。

このメディアプレイヤーは、映像と音声を再生するときに、コンテナの箱から、映像と音声を取り出して再生させるんです。

メディアプレイヤーはそのツールの種類によって扱えるコンテナの種類が予め決まっています。

例えば、QuickTimeplayerで再生できる映像でもWindows Media Playerでは再生できないということになってしまう可能性があるわけです。

コーデックとは

コーデックというのは、いわゆる圧縮方法になります。

動画というのは、映像と音声の両方を扱います。この2つを、そのまま保存してしまうと、短い時間の動画でもかなり大容量になってしまいます。

そこで、コーデックという圧縮方法を活用してデータを小さく抑えて扱いやすくします。

わかりやすくイメージしてもらうとすれば、映像と音声を小さくしてポケットに折りたたむようなイメージです。

そうすることで、移動させやすくなりますし、扱いやすくなりますよね。

その小さく折りたたむ種類がコーデックだと思ってもらうとわかりやすいと思います。

でも、コーデックでデータを折りたたんで圧縮したら、今度はメディアプレイヤーで元に戻して再生する必要がありますよね。

これをデコードと言います。

そこで、対応メディアプレイヤーがもし圧縮したコーデックに対応していない場合、デコードできないのでデータを開けず、動画を再生できないということになってしまいます。

その場合、メディアプレイヤーにコーデックの開き方を教えてあげる必要性が出てきます。これが「対応するコーデックを入れる」と対応になります。

コーデックには様々な種類がありますが、もし、コーデックで迷ったらH.264を選択してください。このコーデックは汎用性が高くて、多くのメディアプレイヤーで再生できるのでかなり一般的に利用されています。

圧縮率も高くデータ容量も小さく抑えることができて、映像の劣化も少ないということでH.264を利用しておけば問題ありません。

音声に関する基礎知識

動画を扱う上で音声の基礎知識は外せません。動画は映像よりもむしろ音声の方が大事です。少しぐらい映像の質が悪くても見ていることができますが、音声の質が悪いと不快で見ることはできません。

そのぐらい音声に関する基礎知識はとても重要になります。ここでは、音声に関して基本的なことについて解説します。

サンプリング周波数とビットレートについて

サンプリング周波数はサンプリングレートなどとも呼ばれていて、アナログ信号からデジタル信号に変換するADコンバーターで1秒間に実行する標本化(サンプリング)処理の回数のことを言います。

標本化(サンプリング)とは:

連続信号を一定の間隔をおいて測定することにより、離散信号として収集することである。アナログ信号をデジタルデータとして扱う(デジタイズ)場合には、標本化と量子化が必要になる。標本化によって得られたそれぞれの値を標本値という。 by wikipedia

つまり、サンプリングレートが大きくなると1秒間に高速でデジタル値に変更できるので、高音質になりやすいということです。

単位を「Hz(ヘルツ)」で表します。

ただ、Hzを大きくするとデータ量もそれに伴って増えるので、周波数を選択してデータ容量をコントロールする必要があります。

音楽CDで採用されているサンプリング周波数

特定の音を正確に記録してしっかりと再生するためには元の音の倍ぐらいの周波数でサンプリングしなくてはなりません。

例えば、音楽CDで利用されているサンプリング周波数は44.1kHzです。

これは、1秒間に44,100回、データを細切れにして、デジタル情報にしたものです。

可聴域を知る

人が音として聞くことができる領域を可聴域と言います。大体15kHz〜20kHzと言われています。ですから、その倍程度の44.1kHzあれば、正確に音を再現することができるというわけです。

ビットレートについて

ビットレートは、「音量を何段階で表現するか」ということを表す数値になります。

例えば一般的に利用されている16bitの場合2の16乗で縦に分割するということになります。

この、bit数が低いと音がザラついた感じになって音の質が下がってしまいます。

bit数もサンプリング周波数と同じで高いほどより多くの情報を表現できますから音質はよくなりますが、それと同時にデータ容量も大きくなってしまいます。

圧縮なしのビットレートを計算する方法

圧縮なしのビットレートを計算するには次のような計算式になります。

圧縮なしビットレート(リニアPCM)=サンプリング周波数 × 量子化ビット数 × チャンネル数(ステレオかモノラルか)

例えばサンプリング周波数が44.1kHzで量子化ビット数が16bitでステレオチャンネルで録音したとします。その時の計算式は次のようになります。

44100Hz × 16bit × 2(ステレオで2ch)=1,411.2kpbs

ビットレートは、bpsで表されて、1秒間に何ビット転送処理をされたかという数値になります。

つまり、このデータが大きければ大きいほど良質な音声だということになります。

音声のコーデックについて

音声コーデックも動画コーデックと同じように圧縮する方法としていくつか種類があります。

音声コーデックには大きく次の3種類があります。

- 非可逆コーデック

- 可逆コーデック

- 非圧縮

非可逆コーデックとは

通称「ロッシー」コーデックと言われています。非可逆コーデックは圧縮したら同じ状態に戻すことができないコーデックです。

非可逆コーデックは音質は多少落ちますが、データ容量を大きく抑えることができるので汎用性が高くて、多くのデータで利用されています。

・MP3

最も利用されている非可逆コーデックの音声データです。互換性が高いということで今でも一番利用されているコーデックです。

・AAC

低、中ビットレート(128kbps)ではmp3よりも1.4倍ぐらい音質がいいと言われています。

映像データをコーデックする際にH.264と一緒にセットで使われる場合が多くて、地上デジタル放送とかBSデジタルなど様々な場所で利用されています。

・WMA

マイクロソフトが開発した音声データです。mp3よりも音質、ファイルサイズともに上ですが、アップル系のデバイスで再生できないということもあって人気がありません。

・Vorbis

あまり聞いたことがない方も多いと思いますが、VorbisはXiph.orgが開発したオープンソースフォーマットの非可逆圧縮音声ファイルです。

mp3は特許の制限を受けるのでその代替品として誰でも自由に使える音声フォーマットを提供することを目指して作られました。

Vorbisは全てのビットレート域でmp3よりも音質がよくてAACと同列か、もしくはそれ以上と言われています。

ちなみに、YouTubeの音声コーデックとして利用されているという点でも有名なコーデックです。

・AC3

DVDやブルーレイの音声コーデックとして利用されています。基本的に動画と一緒に利用されるコーデックなので、これ単体で利用されることはありません。

・MP2

これもDVDで利用される音声コーデックです。最高音質はmp3よりも上ですが、圧縮率はmp3よりも劣るのが特徴です。

可逆コーデック

通称「ロスレス」コーデックと言われています。可逆コーデックは圧縮したデータを元に戻したときに劣化なく戻すことができるコーデックです。

ロスレスなので、どのコーデックを選んでも音質やファイルサイズにそれほど大きな違いはありません。

なので、可逆コーデックを選ぶ時のポイントは、そのコーデックに対応しているソフトがどのぐらい多いかで判断するのがおすすめです。

・ALAC(Appleロスレス)

Apple社が開発したコーデックです。このコーデックはAppleかソニーのmp3プレイヤー以外ではほとんど再生できません。

Final Cut Pro XのデフォルトのエンコードコーデックはこのAppleロスレスコーデックです。

・FLAC

可逆コーデックで一番有名なのがFLACです。通常のFLACファイル (.flac/.fla) だけでなく、Oggファイル (.oga/.ogg) やMatroskaファイル (.mkv/.mka) などのメディアコンテナに格納することができます。

古いので多くの機種で対応しています。ただし、iTunesでは利用できません。

非圧縮

非圧縮は全く圧縮していないので音質はいいですが、データ量がかなり大きくなります。

非圧縮な音声データをリニアPCMと言います。

CD、DVD、音声レコーダーなど多くの場面で利用されています。

本当に高い音質の音声を扱うのであれば、こちらを利用するのが一番おすすめです。

・WAV(ワブ)

WAVはマイクロソフトとIBMによって開発された音声データフォーマットです。主にWindowsで利用されるために作られたデータ形式です。

・AIFF(エーアイエフエフ)

Appleの標準音声フォーマットです。Mac版のWAVファイルに相当します。

最後に

ちょっと専門的すぎてとっつきにくかったかもしれませんが、これらの基礎知識を身につけておくと、今後動画編集をするときに自信を持って編集することができます。

より、良質な動画制作をする上では欠かせない知識ですので、初心者の方はぜひ知識として学んで身につけておいてください。